Co se vlastně děje

V poslední době se množí případy, kdy Perplexity prostě nedělá, co má. Můžete mít vytrénovaný prostor s podrobnými instrukcemi, které jste laďovali týdny, a přesto dostáváte odpovědi, jako by vás AI slyšela poprvé v životě.

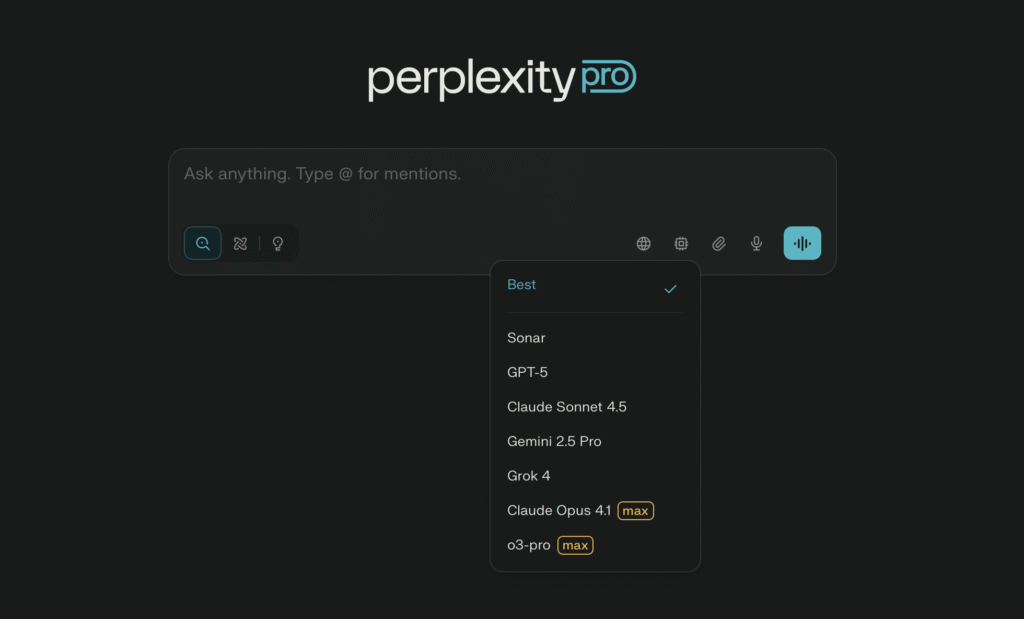

Problém není ve vašich instrukcích ani v tom, že byste něco pokazili. Jádro věci leží v automatickém výběru modelu, který Perplexity používá ve výchozím nastavení. Systém se snaží být chytrý a sám rozhodnout, který model je pro váš dotaz nejvhodnější. Jenže občas se splete.

Když Sonar místo hledání začne odpovídat

Perplexity má vlastní model Sonar, který je vynikající v tom, na co byl stvořený – hledání informací na webu. Když ho ale systém automaticky vybere pro úkol, který vyžaduje přesné dodržování instrukcí, nastává problém. Sonar se prostě nechová jako asistent, který rozumí vašim pokynům. Ignoruje strukturu, kterou jste zadali, nedrží se vašeho tónu a v podstatě dělá, co chce.

Je to trochu jako kdybyste poslali kurýra, aby vám napsal důležitý email. Najde správné údaje, ale text bude vypadat úplně jinak, než jste zamýšleli.

Claude Sonnet 4.5 jako záchrana

Když místo automatického výběru nastavíte model Claude Sonnet 4.5 Reasoning, rozdíl je jako noc a den. Tento model je skutečně schopný pochopit vaše instrukce a důsledně se jich držet. Rozumí kontextu, respektuje strukturu a dokáže přemýšlet nad tím, co po něm chcete.

Musíte ho ale aktivovat ručně před tím, než začnete komunikovat. To znamená jeden krok navíc před každým použitím, ale výsledky to jednoznačně stojí. Dostanete přesně to, co jste chtěli, bez nutnosti opakovat se nebo opravovat chaos.

Zpátky do dob výběru modelů

Ironie celé situace je v tom, že automatizace, která měla uživatelům usnadnit práci, je teď vrací zpátky do stadia, kdy musí rozumět rozdílům mezi jednotlivými modely. Před několika měsíci jste mohli spoléhat na to, že Perplexity vybere správný nástroj. Teď musíte vědět, kdy použít Claude pro dodržování instrukcí a kdy nechat Sonar hledat informace.

Pro někoho, kdo AI používá denně, to není velký problém. Pro běžného uživatele, který jen chce, aby věci fungovaly, je to frustrující krok zpět. Musí se naučit, co který model umí, a přemýšlet nad tím, který zvolit pro konkrétní úkol.

Co to znamená pro vaši praxi

Pokud používáte Perplexity s vlastními prostory, je čas přizpůsobit svůj workflow. Před každým důležitým úkolem, který vyžaduje dodržování instrukcí, si zkontrolujte, který model máte aktivní. Claude Sonnet 4.5 Reasoning by měl být vaší první volbou pro práci s detailními pokyny.

Není to ideální řešení, ale funguje. A dokud Perplexity nevylepší logiku automatického výběru, je to nejjednodušší cesta k předvídatelným výsledkům.