Výpadky stojí víc než si myslíte

AI projekty potřebují obrovské množství dat a ty potřebují být rychle a neustále dostupné. Problém je, že mnoho systémů běžících na výkonných počítačích (HPC) dosahuje pouze 60% dostupnosti. Zbytek času stojí kvůli plánované údržbě nebo neplánovaným výpadkům, kdy se vyměňují komponenty, aktualizuje software nebo napravují chyby.

Takové prostoje nejsou jen nepříjemné – jsou přímo drahé. Podle průzkumu z roku 2024 stojí výpadek 90% organizací minimálně 300 000 dolarů za hodinu. U 41% firem se náklady pohybují mezi 1 až 5 miliony dolarů za hodinu. Čím více máte hardwaru, tím více se pokazí. A čím větší tým máte, tím více se stane lidských chyb (vytáhne se omylem špatný server, kabel nebo disk).

Představte si všechny ty nečinné zdroje: servery, úložiště, síť, zaměstnance, spotřebovanou elektřinu, GPU jednotky, nespokojené datové vědce. To všechno čeká a nejede, zatímco vy platíte.

Jak by úložiště pro AI mělo vypadat

Systém pro náročné AI aplikace musí začínat s paralelním souborovým systémem postaveným podle principů, které používají technologičtí giganti. Když uvážíme obrovské datové sady, se kterými AI výzkum a vývoj pracuje, musí být systém navržen tak, aby zvládl škálovat na tisíce individuálních uzlů s exabajty kapacity.

Takhle pojatá infrastruktura umožňuje lineární škálovatelnost a maximální propustnost pro novou generaci datových úložišť. Bez rychlých sítí a paralelních systémů to prostě nejde. Ale co se často přehlíží, je právě dostupnost celého systému.

Úspěch v implementaci AI projektů závisí na tom, zda má celé datové centrum dostatečný výkon, škálovatelnost a dostupnost pro to, aby GPU jednotky běžely na maximum. Vzhledem k tomu, kolik dnes GPU stojí, je maximalizace návratnosti této investice prostě nutnost.

Žádné selhání

Datové centrum je bojištěm moderního distribuovaného počítání. Selhání systémů jsou běžná a problémy nejsou otázkou “jestli”, ale “kdy”. Proto je potřeba navrhovat systémy se 100% dostupností. To znamená, že redundance musí být zabudovaná přímo do architektury.

Je to logické. Pokročilé technologie se neposunou kupředu se systémy, které zažívají výpadky. IT průmysl dlouho akceptoval, že prostoje jsou nutné zlo potřebné pro aktualizace a údržbu. Moderní pohled je ale jiný – očekáváme nový standard toho, co je možné.

Proto je třeba stavět úložiště od základu tak, aby bylo odolné vůči selhání platformy. Velcí poskytovatelé cloudových služeb už normalizovali očekávání, že systémy jsou dostupné 24/7 s plným výkonem. Odolnost vůči chybám vyžaduje software, který “nevěří” hardwaru pod sebou. Základní jednotkou je cluster, který by měl mít minimálně čtyři uzly.

Údržbová okna jsou minulostí

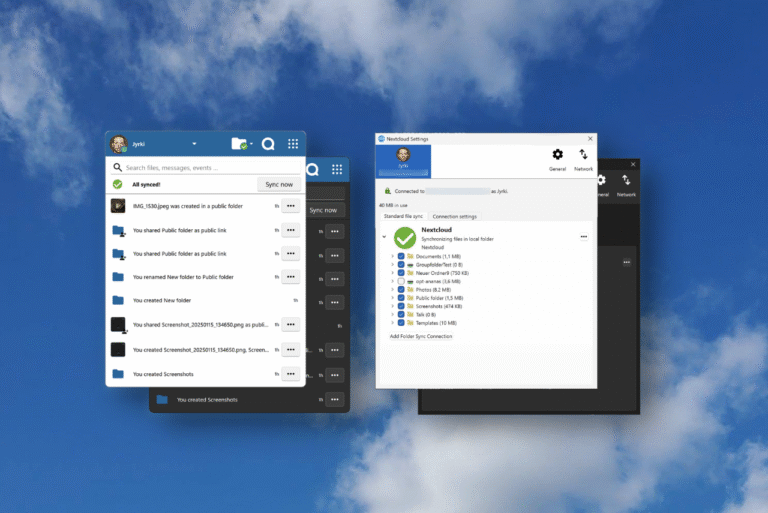

Klíčovou vlastností systémů přizpůsobených pro práci s AI je absence údržbového okna. Použití modulární a heterogenní architektury znamená, že nejsou potřeba plánované prostoje pro upgrady a aktualizace.

To pokrývá všechno, co administrátoři úložiště a operátoři hardwaru běžně potřebují dělat: aktualizace, opravy hardwaru, výměny komponent, rekonfigurace, aktualizace jádra a bezpečnostní záplaty. Starší systémy úložiště spoléhající na duální kontroléry mají více bodů selhání a jejich údržbová okna narušují provoz, což znemožňuje kontinuální operace.

Cluster je mnohem lepší řešení. Modularita tohoto přístupu poskytuje o řád lepší úroveň redundance. Uzly mohou být vyřazeny z provozu, jejich komponenty vyměněny nebo software aktualizován, a pak se jednoduše znovu připojí ke clusteru. To umožňuje skutečnou odolnost vůči chybám a nepřerušovaný provoz.

Flexibilita a kompatibilita

Potřeby současných i budoucích AI úloh budou vyžadovat úložiště, které zvládne hybridní architektury. Schopnost kombinovat a integrovat novější systémy s předchozími investicemi nelze přehlížet. Kompatibilita je v tomto smyslu rozpočtovou otázkou.

Ideální systém úložiště má uživatelský prostor bez vlastních modulů jádra nebo ovladačů. Důsledkem je, že systém může spravovat personál se základními znalostmi operačního systému Linux. Pokud nastane problém, nemusíte čekat na jediného experta, který dorazí do datového centra.

Clustery by měly být postaveny minimálně na čtyřech uzlech, ale také musí být schopny škálovat až na tisíce uzlů, pokud je to nutné. Každý cluster by měl být schopen řešit selhání bez prostojů a běžnou údržbu provádět bez výpadků. Pokročilé projekty jako umělá inteligence potřebují kontinuální provoz.

Co přinese budoucnost

Kapacita dat a spotřeba energie umělé inteligence poroste. Už teď se odhaduje, že AI zabírá asi 20% globální spotřeby energie datových center a do konce roku se toto číslo má zdvojnásobit. Chytřejší AI prostě budou potřebovat ještě více úložného prostoru.

Samotný výkon vás nikam nedostane, jakmile začnete s produkcí projektů o petabajtech složitosti. Výkon vypadá skvěle na papíře, ale realita je jiná. Je to jako s závodním autem – jakmile vyjede na trať, údržba se stane problémem.

Spolehlivost a výkon zabrání tomu, aby auto většinu času stálo v garáži na opravách. Proto konstrukce systémů úložiště vyžaduje efektivní, flexibilní a hardware-agnostické systémy, které budou sloužit pro budoucnost, jež se buduje dnes. Systémy musí být schopné provádět kontroly všeho od začátku do konce, včetně síťových připojení a disků.

Zdroje: TechRadar